В сети набирает обороты скандал, связанный с алгоритмами Facebook — некоторые пользователи столкнулись с неприятным багом. Об этом рассказали в Engadget.

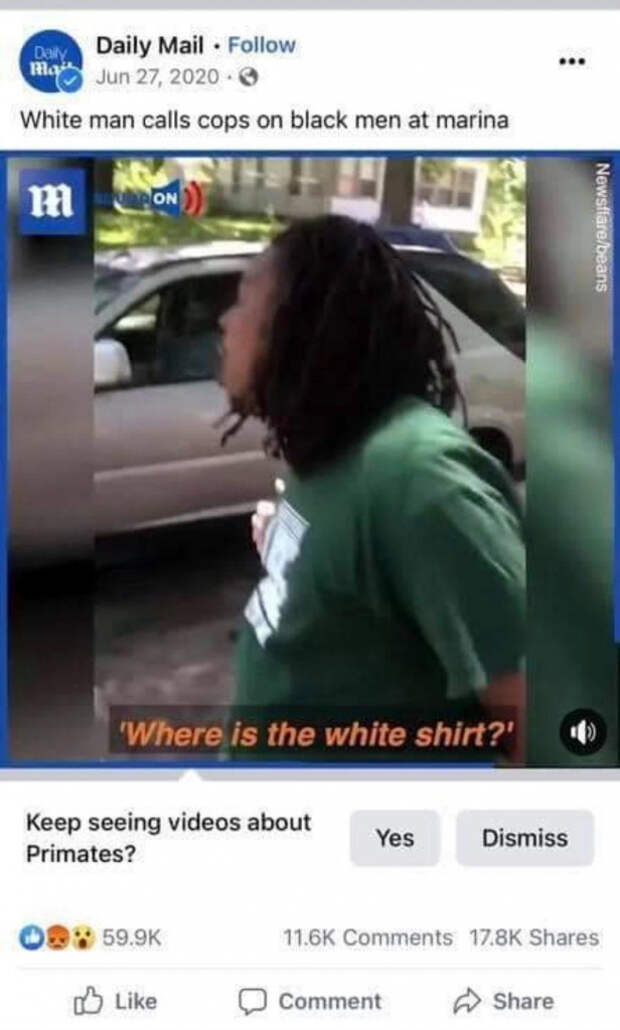

Согласно источнику, в интернете появились возмущенные отзывы относительно поведения рекомендаций в Facebook. По словам пользователей, при просмотре видео с участием чернокожих мужчин, они неоднократно наблюдали подсказку с рекомендацией от нейросети.

«[k]eep seeing videos about Primates?»

Пресс-секретарь Facebook Дэни Левер уже ответил на претензии:

Хотя мы добились больших успехов в области нашего ИИ, мы знаем, что он не идеален, и нуждается в постоянных доработках. Мы приносим извинения всем, кто мог видеть эти оскорбительные рекомендации»

Стоит отметить, что для Facebook эта проблема не нова. Ранее в этом году компания создавала специальные «курсы» для своих нейросетей, чтобы они отличали людей с разным цветом кожи. Facebook наняла специальных актеров, которых гримировали под разных цвет кожи, национальность и пол — всё это для того, чтобы обучить ИИ различать людей. Кроме того, компания использовала для обучения нейросети базу из 40 тысяч видеороликов с участием более 3000 актеров. Очевидно, всего этого оказалось недостаточно, чтобы ИИ сумел безошибочно определять темнокожих людей в любых ситуациях и видеороликах.

В целом, нейросети различных компаний не впервые допускают такие ошибки. Например, в 2015 году алгоритмы Google пометили фотоснимки двух чернокожих мужчин тегом «гориллы», после чего американские СМИ обнаружили, что Google вообще исключила слово «горилла» из своих баз поиска и тегов.